蘋果發布 DataComp-LM 開源模型:引領人工智慧新時代

《愛瘋日報》報導,蘋果公司的 Apple Intelligence 研究團隊最近宣布推出兩個全新的語言模型,這些模型雖然體積小巧,但性能卻非常強大。

這些模型屬於 DataComp 計劃的一部分,目的是與其他領先的訓練模型,如 Llama 3 和 Gemma 競爭,甚至超越它們。

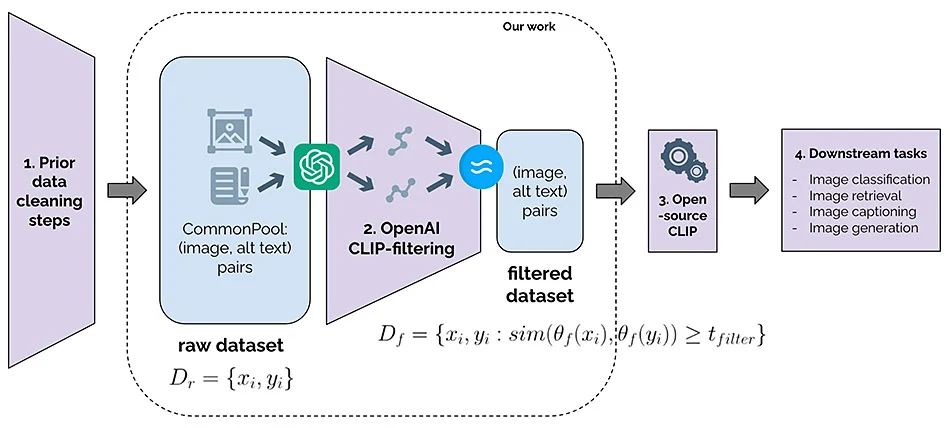

高品質資料訓練框架

這些語言模型提供了標準的訓練框架,專門用於提升人工智慧生成器(如 ChatGPT)的性能。

這包括模型架構設計、參數設定及資料集過濾技術,確保人工智慧引擎獲得高品質的訓練資料。

雙模型設計:70 億與 14 億參數

蘋果提交給 DataComp 計劃的文件中包含了兩個模型:一個擁有 70 億參數的大模型,另一個則是 14 億參數的小模型。

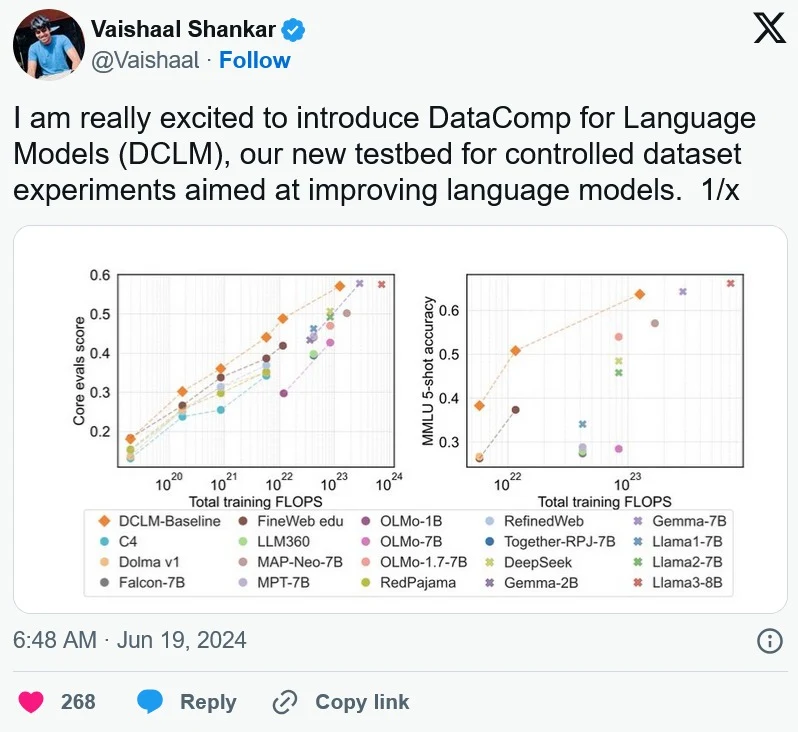

根據基準測試結果,70 億參數模型的性能比之前的頂尖模型 MAP-Neo 高出 6.6%。

優化運算能力與資料集

DataComp-LM 模型在完成基準測試所需的運算能力降低了 40%。

在使用開放資料集的模型中,這些新模型的表現最佳,甚至在與使用私有資料集的模型相比時也具有很強的競爭力。

全面開放的研究成果

蘋果公司完全開放了這些模型的所有資料,包括資料集、模型權重和訓練程式碼,供其他研究人員使用。

在大規模多任務語言理解基準測試(MMLU)中,這兩個模型都取得了優異的成績,足以媲美商業模型。

蘋果展現人工智慧領導地位

在今年 6 月舉行的 WWDC 大會上,蘋果首次發布了 Apple Intelligence 和 Private Cloud Compute,這讓那些質疑蘋果在人工智慧應用上的進展的聲音消失無蹤。

蘋果的機器學習團隊在大會前後發布的研究論文,進一步證明了蘋果在人工智慧領域的領導地位。

社群研究專案的重要性

蘋果推出的這些新模型並不打算用於任何未來的蘋果產品,而是作為社群研究項目的一部分,旨在展示小型和大型資料集在訓練人工智慧模型上的改進效果。

蘋果的機器學習團隊一向與更廣泛的人工智慧社群分享研究成果,這些資料集、研究筆記和其他資產都可以在 HuggingFace.co 上找到,這是一個專注於推動人工智慧社群發展的平台。

蘋果引領人工智慧未來

蘋果公司透過發布 DataComp-LM 開源模型,再次展示了其在人工智慧研究領域的領導地位。

這些新模型不僅提升了訓練效率和性能,還進一步推動了人工智慧社群的發展,為未來的人工智慧應用奠定了堅實的基礎。

《愛瘋日報》表示,蘋果公司將繼續致力於創新與研究,為全球用戶帶來更多突破性的技術成果。